Современные помощники в принятии неправильных решений

Реальность не реальна

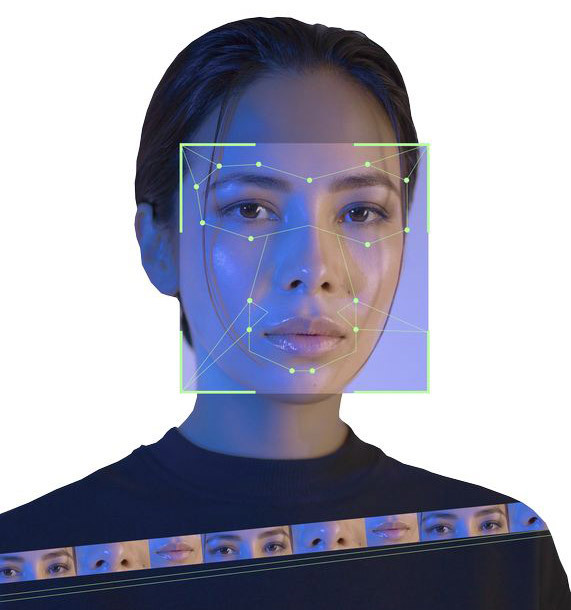

Термин deepfake демонстрирует смысл технологии через симбиоз двух понятий: deep learning (глубинное обучение) и fake (подделка). В общих чертах дипфейки представляют собой искусственно созданные видео, фотографии или аудиозаписи, где лица или голоса людей подменяются с помощью нейросетей. В каком‑то смысле эта технология заставляет человека говорить то, что он не произносил, и делать то, что он никогда не делал.Говоря техническим языком, в основе процесса создания дипфейк‑видео лежит работа генеративно‑состязательных нейронных сетей, обрабатывающих выборку данных с целью распознавания лица человека, его характерных черт и мимики для создания имитации.

С генерацией аудиодипфейков дела обстоят схожим образом. В качестве исходных данных могут использоваться аудиозаписи из интервью, публичных выступлений, голосовых сообщений, телефонных разговоров и даже приватных бесед с умной колонкой. Записи дробятся на фрагменты и направляются на изучение алгоритмам глубокого обучения для создания голосовой модели.

Сегодня для подделки голоса достаточно всего несколько случайных коротких фраз. Однако, чтобы синтетический голос правильно делал паузы, ударения, использовал междометия и был, собственно говоря, характерен, потребуется куда больше информации.

Существует четкая зависимость: чем больше исходного материала анализируется, тем достовернее получится подделка. В этом случае происходит самое настоящее клонирование или синтез речи. Итоговый результат практически невозможно отличить от реального, не обладая специализированными технологиями, выявляющими подделку по мельчайшим аномалиям и артефактам.

Однажды в сказке

Для того чтобы лучше понять, какую опасность таят в себе дипфейки, давайте вернемся к истокам их появления. Сама идея подмены лиц уходит корнями в глубокую древность, однако история дипфейка как технологии берет начало в лихих 90‑х. В то время повальная компьютеризация только начинала давать свои плоды и подобным инструментарием обладали исключительно эксперты в области спецэффектов. Позже программное обеспечение вышло в открытый доступ и технология создания дипфейков перешла во влажные руки интернет‑сообщества.Свое лицо дипфейки начали обретать в 2014‑м, когда американским студентом Яном Гудфеллоу был разработан программный метод получения новых мультимедийных материалов с помощью анализа баз данных. Парень автоматизировал процесс обучения двух нейронных сетей, когда одна из них распознает и генерирует лица или голоса, а другая анализирует результаты и дает им оценку. Но наука — это скучно, поэтому потребовалось еще несколько лет, чтобы этот метод громко выстрелил и получил название deepfake.

В 2017‑м анонимный пользователь портала Reddit c говорящим псевдонимом deepfakes опубликовал видео порнографического характера, в котором «снялись» голливудские звезды. Ролик стремительно выпилили с платформы, однако интернет помнит все, поэтому картина не единожды удостаивалась повторного широкого проката, впечатляющего по своим масштабам, а представленная огромной аудитории новая модная технология замены лиц мгновенно завирусилась в сети.

Новое развлечение вызвало нешуточный интерес людей по всему миру, и крупные цифровые платформы, осознав стремительно растущую дыру в безопасности, попытались запихнуть джина обратно в бутылку. Объединив усилия, они принялись подтирать информационное поле от всех ссылок и упоминаний дипфейк‑технологий. Однако введенные ограничения и запреты лишь усиливали интерес любознательных пользователей. А благодаря развитию технологий за несколько лет порог вхождения в процесс производства дипфейков существенно снизился. И сегодня уже не нужно быть сеньором‑программистом, достаточно обладать базовыми компьютерными навыками и уметь оперировать типовым набором программного обеспечения. Это уже под силу многим дошколятам.

Важно отметить, что технология, которая попала в открытый доступ для пользователей, — лишь пенка с чашки кофе. Можно только гадать, что скрывается на дне кофейной гущи.

Феномен лжи

Две главные причины бешеной популярности дипфейков у интернет‑пользователей, а также мошенников и экстремистов — простота создания и сильнейший воздействующий эффект. Тенденцией последних нескольких лет стал взрывной рост использования дипфейков для дискредитации публичных лиц, таких как политики, журналисты и другие лидеры мнений.

Пагубному воздействию дипфейков неоднократно подвергались актеры, музыканты и прочие знаменитости. И если в их случае дипфейк‑контент по большей части безобиден, то использование образов политических деятелей можно расценивать как инструмент деструктивного влияния на общественное мнение.

Технология с каждым днем прогрессирует, и если раньше отличить реальную речь или образ человека на видео было достаточно просто, то в скором времени разницы с оригиналом не останется. Грань реальности постоянно истончается и размывается, и каждый шаг развития неумолимо приближает мир к тотальной симуляции, где никто не сможет отличить правду от лжи.Нет ничего криминального в том, чтобы подшутить над менеджерами службы доставки, заказав пиццу голосом знаменитого политика. Но для понимания потенциальной опасности представьте себе следующую ситуацию. Совещание руководителей какого‑нибудь крупного государственного предприятия в онлайн‑режиме. Все тихо и спокойно, участники конференц‑связи в штатном режиме делятся докладами, озвучивают планы работ и обсуждают текущие задачи. И вдруг в онлайн врывается директор компании, начинает неистово кричать и требовать, например, срочно вывести все деньги с корпоративных счетов и перенаправить их куда‑то «за море». Да, скорее всего, участники собрания сильно удивятся такому поведению, ведь для этого не было никаких видимых предпосылок. Однако высока вероятность, что у присутствующих даже не возникнет и мысли о том, что «царь‑то ненастоящий». Так и работают дипфейки...

А теперь давайте представим другую ситуацию. Передовая, на которой плотным строем стоят солдаты, готовые сдерживать натиск противника на поле боя. И вдруг рупор начинает вещать строгим голосом главнокомандующего, чтобы те бросали оружие, сдавались в плен или бежали врассыпную. Я уверен, что, дочитав это предложение до конца, даже вы почувствовали легкий приступ паники или замешательства.

Война по доверенности

На планете безраздельно властвует культура отмены. Всем нам приходится жить в мире условно обиженных. Куда ни ткни, попадешь в человека, который чем‑то недоволен: то ли своим положением в обществе, то ли отношением общества к нему, то ли, один черт знает, чем еще. Это нездоровое состояние социума — благодатная почва для расцвета конфликтов по причине любой розни.

В качестве наглядного примера можно взять особо чувствительное к любому воздействию духовно‑конфессионное пространство. В 2015‑м в редакцию французского журнала Charlie Hebdo ворвались исламские радикалы. Они убили 12 человек и почти вдвое больше ранили. Поводом послужила опубликованная журналом карикатура на мусульманского пророка Мухаммеда. Только представьте, какими могут быть последствия, если дипфейк‑технологии начнут массово применяться в целях разжигания подобной вражды. Так и до новых крестовых походов можно доиграться.

С развитием дипфейк‑технологий неизбежно возникнут опасные прецеденты в судебной сфере. В мире уже не единичны случаи попыток использования дипфейк‑материалов в качестве доказательной базы в суде. К счастью, пока что такие «доказательства» не приобщаются к реальным материалам дела. Однако со временем может сформироваться презумпция недоверия к любым цифровым свидетельствам, и в буквальном смысле возникнет необходимость предоставлять суду гарантии их реальности.Сейчас дипфейки широко используются для создания фальшивых новостей, откровенной дезинформации, подрыва доверия к власти или вызова социального разлада. Фальшивые видеозаписи с участием политических лидеров могут привести к нестабильности или даже возникновению международных конфликтов.

Можно легко представить ситуацию применения дипфейк‑технологий для создания хаоса в целых регионах мира. Ведь сегодня главный замысел достижения геополитических целей связан не только с боевыми действиями, но и культивированием социальной напряженности, внутреннего протеста в обществе и взращиванием идеологически «правильного» поколения людей — опоры другого режима. Иначе говоря, ведение гибридной войны руками и ресурсами противника на его же территории. Такому орудию, как дипфейки, на этом поле боя нет равных.

Нет пути назад

Можно бесконечно долго ждать, когда дерево сгорит самостоятельно, а из его пепла поднимутся новые побеги, либо, не дожидаясь пожара, срубить под корень и дать возможность более мелким растениям вырасти. Но человечество дорожит своим мировым древом, чтобы просто его сжечь или срубить. Оно, подобно мифическому Иггдрасилю, раскинуло ветви и корни на все цифровое пространство и переплелось со всеми сферами жизни. Остается только попытаться адаптироваться к ежеминутно изменяющейся мировой конъюнктуре.

Мы стоим на распутье, и приходится постоянно идти на компромиссы. Ведь впереди таится пугающая неизвестность, а обратный путь страшит многих не меньше — это возврат в тот самый аналоговый мир бумажной информации. Как показывает жизнь, он куда надежнее и безопаснее.

Проблема кроется не в технологии дипфейков как таковой или ее доступности. Если раньше информация распространялась через телеграфные агентства и сарафанное радио, то за сравнительно короткий промежуток времени способ ее передачи мутировал в глобальную индустрию формирования взглядов, настроений общества и даже в инструмент ведения войн.

В прежние времена для лоббирования каких‑то интересов внутри государств приходилось выстраивать сложные агентурные сети и воздействовать очень осторожно. Но сегодня весь мир открыт, и достаточно одного короткого ролика в TikTok, чтобы устроить такой пожар, которому позавидовало бы любое разведывательное бюро в период холодной войны.

Луч света

На первый взгляд может показаться неочевидным, но в ряде случаев дипфейки могут принести огромную пользу обществу. Взять, например, сферу образования. Если уж что‑то и нужно оцифровывать, так это то, что невозможно воспроизвести или показать в учебном процессе классическим методом. Уроки истории стали бы куда интереснее, если бы они иллюстрировались дипфейками знаменитых людей прошлого: исторических личностей, деятелей науки и культуры. Часть школьной программы они могли бы поведать как свою личную историю.

Технологии глубокого обмана являются инструментами двойного назначения. Их не нужно бояться, но их нужно знать и контролировать. Наша страна входит в электоральную кампанию, и уже сейчас ощущается злонамеренное воздействие извне. И с каждым днем наплыв дипфейков будет только увеличиваться. Для предотвращения любых негативных последствий их применения важно иметь критический взгляд на то, что мы видим и слышим.Умение анализировать информацию поможет отличить подлинные материалы от лживых и замедлит распространение дезинформации.

Существует хорошее выражение: хочешь чистой воды, обратись к источнику. В современном мире людям следует чаще проверять информацию, полученную любым из способов.

ФАКТ

Самый простой и распространенный способ мошенничества — запись голоса жертвы, на основе которой генерируется звуковая дорожка. Грамотно созданная на базе ключевых фрагментов запись вкупе с украденными персональными данными позволяет легко выдать себя за другого человека. И будь то сотрудник банка или близкий родственник, распознать подделку непросто.

КСТАТИ

Ко всему следует относиться с долей скепсиса. Истина всегда будет находиться где‑то между. И это касается не только дипфейков.