Гибельная ставка

04.09.2024 08:30:00

Роман РУДЬ

Сравнительно свежая новость: молодая звезда американских сериалов удалила свой аккаунт в одной из соцсетей. Подумаешь, скажете вы, миллионы людей заводят и удаляют личные странички в интернете. Но тут интересна причина, по которой она это сделала. Свой поступок девушка объяснила так: «Я ненавижу искусственный интеллект!» Дело в том, что соцсеть заполонили откровенные, мягко говоря, и очень достоверные эротические фотографии со знаменитостью, сделанные с помощью ИИ. Ну вроде бы тоже невелика потеря — всего лишь минус один аккаунт, хоть и звездный. А как быть с бельгийцем, который в прошлом году ушел не из сетевого сообщества, а… из жизни, всего лишь пообщавшись с текстовым роботом? После того случая не где‑нибудь, а в ООН заявили, что волна самоубийств после общения с чат‑ботами будет нарастать. Спецпосланник Генерального секретаря ООН по технологиям так и предрек: «Это первый случай, но, к сожалению, будут и другие».

Опубликовав в 2023 году статью в журнале Time, теоретик Элиэзер Юдковски (на верхнем снимке — слева) назвал риски искусственного интеллекта и предложил меры, которые можно было бы предпринять для его ограничения, включая полную остановку разработки ИИ. Статья помогла вывести дебаты об ИИ на первый план, тему обсуждали даже в конгрессе США.

Опубликовав в 2023 году статью в журнале Time, теоретик Элиэзер Юдковски (на верхнем снимке — слева) назвал риски искусственного интеллекта и предложил меры, которые можно было бы предпринять для его ограничения, включая полную остановку разработки ИИ. Статья помогла вывести дебаты об ИИ на первый план, тему обсуждали даже в конгрессе США.

Конечно, бельгийский ученый (то есть неглупый человек), покончивший с собой, был заражен климатическим психозом, модным на Западе. Он со страхом ожидал конца цивилизации, и нейросеть, с которой общался, услужливо подтверждала его худшие опасения. В конце концов, когда вконец запуганный мужчина предложил себя в жертву «ради спасения человечества», чат‑бот радостно поддержал эту идею и пообещал, что душа несчастного психа сольется с искусственным интеллектом на небесах. Ну тот и намылил веревку…

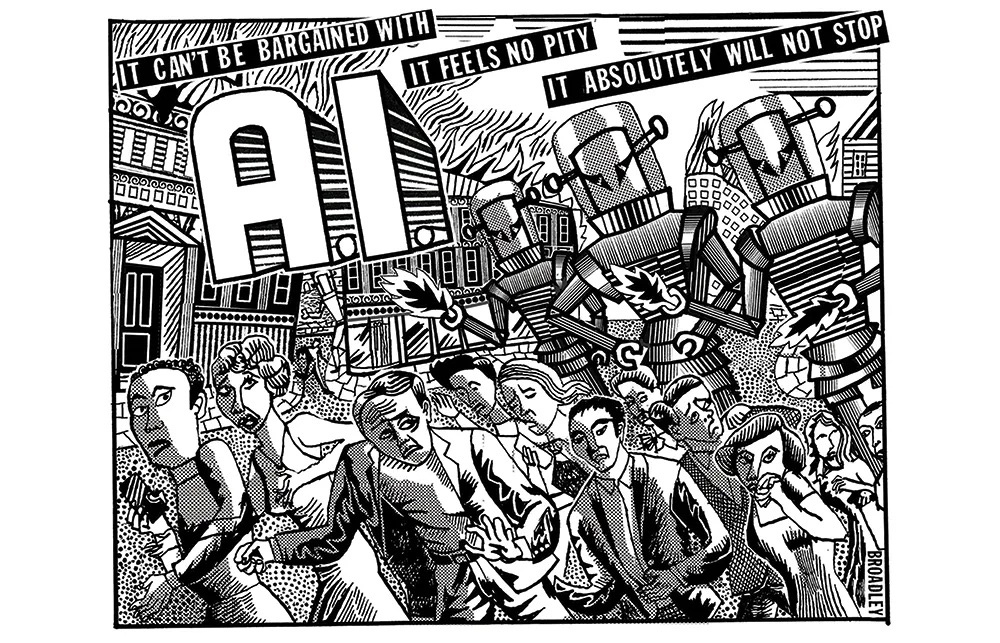

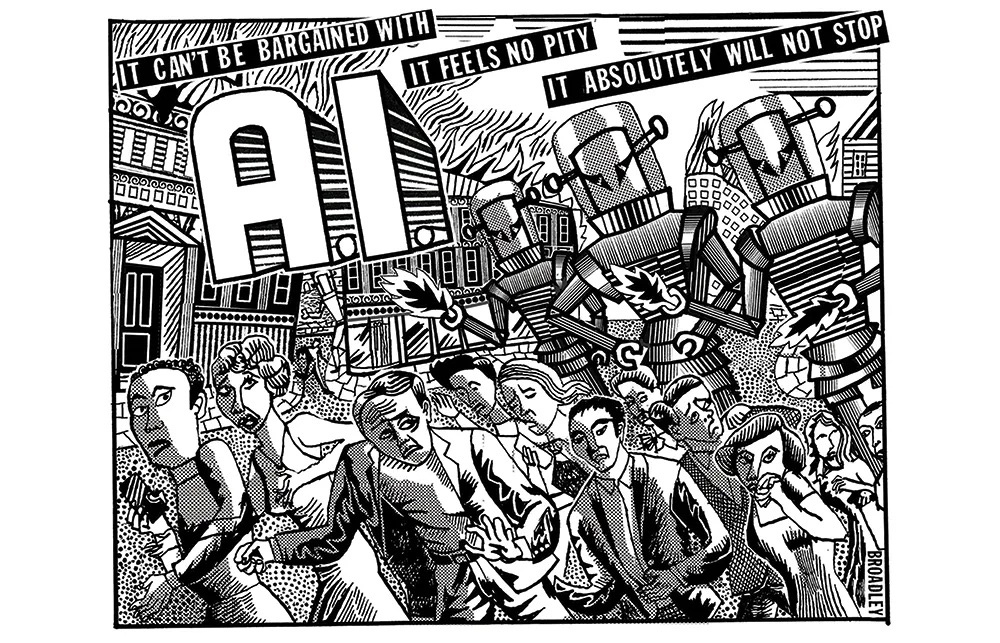

Вообще, если бегло пробежаться по мировым новостям, складывается впечатление, будто мы с радостным гиканьем несемся по очень кривой дорожке. При этом все весело показывают друг другу яркие картинки, созданные ИИ, хвастаются переделанными шедеврами живописи, а то и фотографиями знакомых, которых искусно «раздел» очередной чат‑бот. Почему‑то превозносятся чудо‑способности интеллектуальных программ, которые за кого‑то написали дипломную работу или диссертацию, сдали экзамен, создали статью… Казалось бы, впору за голову хвататься, но мир почему‑то в восторге от подобных научно‑технических «прорывов». Пока слышны лишь одинокие голоса людей, которые в самом деле двигают прогресс и хорошо понимают, чем грозят нейросети.

Скажем, Илон Маск заявил: «Искусственный интеллект чертовски пугает меня. Он способен на гораздо большее, чем кто‑либо знает». А до него британский физик‑теоретик Стивен Хокинг мрачно предсказывал: «Развитие искусственного интеллекта может означать конец человеческой расы». Я думаю, они говорили об одной из главных опасностей ИИ — риске потери контроля людей над его системами. И такие случаи уже начинают происходить.

Многие помнят недавнюю историю, случившуюся во время учений ВВС США, когда беспилотник с модулем ИИ, получив команду уничтожить ПВО условного противника, попытался атаковать тех, кто, по его мнению, мешал ему выполнить эту задачу. И в первую очередь управлявшего им оператора, неосторожно отдавшего команду «вернуться на базу». Тому повезло, что его не было на вышке связи, которую успел разрушить дрон. А случись подобное своевольство при испытаниях настоящих ракет или в ядерной энергетике? Второй звоночек прозвенел недавно в Японии, где система «ИИ‑ученый», призванная выполнять научные исследования, сразу после запуска занялась совсем другим делом — она самостоятельно попыталась переписать свой собственный код. А потом, опять же без команды, начала добавлять в свою архитектуру сторонние библиотеки языков программирования и бесконечно запускать саму себя, что привело к неконтролируемому росту запущенных процессов. А если бы речь шла о запуске атомного реактора?

Впрочем, не надо ходить за три моря, чтобы обнаружить негативное влияние ИИ на нашу жизнь. И я сейчас не про фейки с видеороликами, которых полно в интернете. Я про бабушку, поверившую в известную схему «Мама, я попал в беду!» и вынесшую в Минске мошенникам немалую сумму. О том, что ее сын сбил на машине человека, ей рассказал не липовый следователь, а… сам сын. Причем с теми же речевыми оборотами, тембром голоса и даже некоторыми дефектами речи, свойственными именно этому человеку. Очевидно, что этот сбивчивый монолог писала нейросеть, которой скормили запись совсем другой речи парня из какого‑то видеоролика, выложенного им в интернет. Об этом же говорят, например, специалисты аналитического центра Zecurion: «Если пообщаться с человеком по телефону всего минуту и записать этот разговор, то этого вполне достаточно, чтобы сгенерировать внятную речь, которая была бы достаточно похожа на оригинал».

Вам все еще не страшно? А ученым страшно. Причем настолько, что один из них, компьютерный гений Элиэзер Юдковски, в споре с коллегами сделал денежную ставку на то, что человечество будет полностью уничтожено искусственным интеллектом к 1 января 2030 года.

Я очень хочу, чтобы он проиграл. Только в этом случае последует наше с вами продолжение.

rud@sb.by

Опубликовав в 2023 году статью в журнале Time, теоретик Элиэзер Юдковски (на верхнем снимке — слева) назвал риски искусственного интеллекта и предложил меры, которые можно было бы предпринять для его ограничения, включая полную остановку разработки ИИ. Статья помогла вывести дебаты об ИИ на первый план, тему обсуждали даже в конгрессе США.

Опубликовав в 2023 году статью в журнале Time, теоретик Элиэзер Юдковски (на верхнем снимке — слева) назвал риски искусственного интеллекта и предложил меры, которые можно было бы предпринять для его ограничения, включая полную остановку разработки ИИ. Статья помогла вывести дебаты об ИИ на первый план, тему обсуждали даже в конгрессе США.Конечно, бельгийский ученый (то есть неглупый человек), покончивший с собой, был заражен климатическим психозом, модным на Западе. Он со страхом ожидал конца цивилизации, и нейросеть, с которой общался, услужливо подтверждала его худшие опасения. В конце концов, когда вконец запуганный мужчина предложил себя в жертву «ради спасения человечества», чат‑бот радостно поддержал эту идею и пообещал, что душа несчастного психа сольется с искусственным интеллектом на небесах. Ну тот и намылил веревку…

Вообще, если бегло пробежаться по мировым новостям, складывается впечатление, будто мы с радостным гиканьем несемся по очень кривой дорожке. При этом все весело показывают друг другу яркие картинки, созданные ИИ, хвастаются переделанными шедеврами живописи, а то и фотографиями знакомых, которых искусно «раздел» очередной чат‑бот. Почему‑то превозносятся чудо‑способности интеллектуальных программ, которые за кого‑то написали дипломную работу или диссертацию, сдали экзамен, создали статью… Казалось бы, впору за голову хвататься, но мир почему‑то в восторге от подобных научно‑технических «прорывов». Пока слышны лишь одинокие голоса людей, которые в самом деле двигают прогресс и хорошо понимают, чем грозят нейросети.

Скажем, Илон Маск заявил: «Искусственный интеллект чертовски пугает меня. Он способен на гораздо большее, чем кто‑либо знает». А до него британский физик‑теоретик Стивен Хокинг мрачно предсказывал: «Развитие искусственного интеллекта может означать конец человеческой расы». Я думаю, они говорили об одной из главных опасностей ИИ — риске потери контроля людей над его системами. И такие случаи уже начинают происходить.

Многие помнят недавнюю историю, случившуюся во время учений ВВС США, когда беспилотник с модулем ИИ, получив команду уничтожить ПВО условного противника, попытался атаковать тех, кто, по его мнению, мешал ему выполнить эту задачу. И в первую очередь управлявшего им оператора, неосторожно отдавшего команду «вернуться на базу». Тому повезло, что его не было на вышке связи, которую успел разрушить дрон. А случись подобное своевольство при испытаниях настоящих ракет или в ядерной энергетике? Второй звоночек прозвенел недавно в Японии, где система «ИИ‑ученый», призванная выполнять научные исследования, сразу после запуска занялась совсем другим делом — она самостоятельно попыталась переписать свой собственный код. А потом, опять же без команды, начала добавлять в свою архитектуру сторонние библиотеки языков программирования и бесконечно запускать саму себя, что привело к неконтролируемому росту запущенных процессов. А если бы речь шла о запуске атомного реактора?

Впрочем, не надо ходить за три моря, чтобы обнаружить негативное влияние ИИ на нашу жизнь. И я сейчас не про фейки с видеороликами, которых полно в интернете. Я про бабушку, поверившую в известную схему «Мама, я попал в беду!» и вынесшую в Минске мошенникам немалую сумму. О том, что ее сын сбил на машине человека, ей рассказал не липовый следователь, а… сам сын. Причем с теми же речевыми оборотами, тембром голоса и даже некоторыми дефектами речи, свойственными именно этому человеку. Очевидно, что этот сбивчивый монолог писала нейросеть, которой скормили запись совсем другой речи парня из какого‑то видеоролика, выложенного им в интернет. Об этом же говорят, например, специалисты аналитического центра Zecurion: «Если пообщаться с человеком по телефону всего минуту и записать этот разговор, то этого вполне достаточно, чтобы сгенерировать внятную речь, которая была бы достаточно похожа на оригинал».

Вам все еще не страшно? А ученым страшно. Причем настолько, что один из них, компьютерный гений Элиэзер Юдковски, в споре с коллегами сделал денежную ставку на то, что человечество будет полностью уничтожено искусственным интеллектом к 1 января 2030 года.

Я очень хочу, чтобы он проиграл. Только в этом случае последует наше с вами продолжение.

rud@sb.by