Недавно в Витебске мошенники написали женщине в мессенджере с аккаунта ее начальника, который приказал выполнить все указания некоего сотрудника правоохранительных органов. А тот предложил «задекларировать» деньги, переведя их на определенные счета. Женщина выполнила указания и лишилась почти 45 тысяч рублей. От подобной схемы, называемой fake boss, еще можно защититься, просто перезвонив своему руководителю. Но как быть, если начальник сам звонит вам по видеосвязи и раздает странные приказы хорошо знакомым вам голосом? Злоумышленники уже неплохо освоили технологию «глубокого обмана» (deep fake) и могут использовать ее не только для воровства ваших денег…

Как это работает?

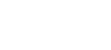

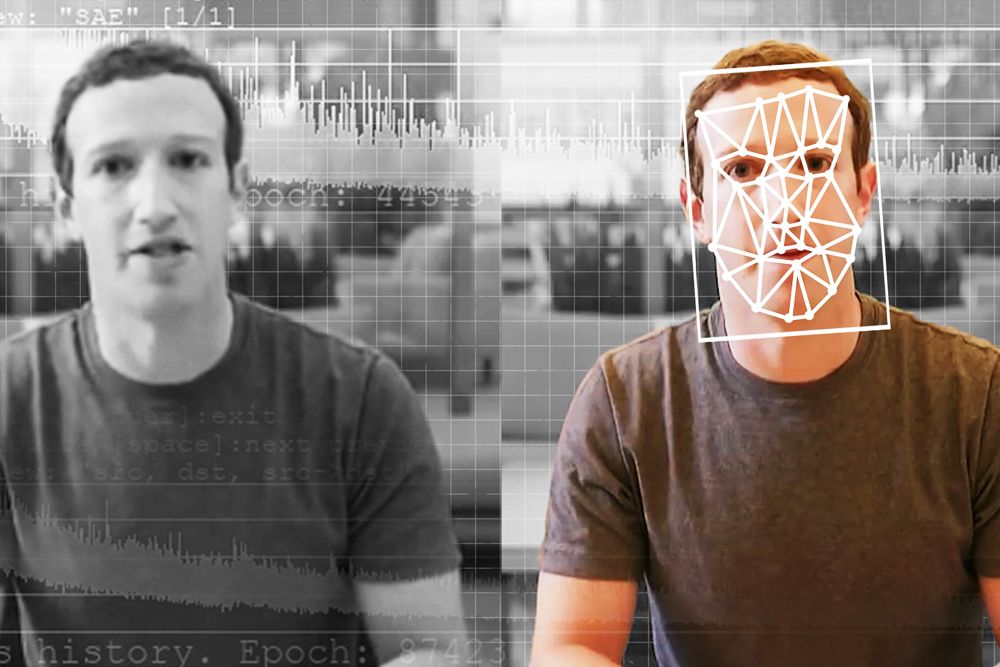

Кратко говоря, с помощью нейросети мошенники создают реалистичное видеоизображение человека. Затем сгенерированный образ рассылают его друзьям или родным через мессенджеры или социальные сети. В коротком фальшивом видеоролике виртуальный герой, голос которого иногда сложно отличить от голоса прототипа, рассказывает якобы о своей проблеме (болезнь, ДТП, увольнение) и просит перевести деньги на определенный счет.Если подробнее, то, чтобы создать цифровую копию конкретного человека, злоумышленники используют фото и видео, чаще всего выложенные им самим в соцсетях. Запись образцов голоса получают, несколько раз позвонив выбранному объекту, якобы ошибившись номером. Для подделки голоса достаточно всего нескольких случайных коротких фраз. Правда, для более продолжительного фальшивого разговора нужно больше информации, тогда в дело идут аудиозаписи из интервью, публичных выступлений, голосовых сообщений и даже приватных бесед с умной колонкой.

Затем в дело вступают современные генеративно-состязательные нейронные сети и алгоритмы глубокого обучения. Они обрабатывают загруженные данные с целью распознавания лица человека, его характерных черт и мимики, создания достоверной голосовой модели. И получается имитация, которую крайне сложно отличить от реальности.

В итоге моей пожилой соседке звонят мошенники, разговаривающие голосом… ее сына. Они просят денег с теми же модуляциями и запинками, даже с небольшими дефектами речи, которые есть у живого человека. У нее и мысли не мелькнуло, что общается с искусственным интеллектом. Послушно вынесла «курьеру» требуемую сумму…

Но на фоне этого вала мошеннических приемов, призванных выманивать деньги у населения, мало-помалу начинают возникать и более тревожные явления.

Хаос и сумятица

Помните, как в октябре 2023‑го Александр Лукашенко рассказывал о фейке в отношении себя — по сети разлетелось видео, где он якобы весьма живо разговаривал на французском языке:— Кто-то знает в мире или даже в Беларуси, что я вообще не разговариваю на французском языке? — сказал Президент, выступая тогда перед молодежью во Дворце Независимости. — Слушают, а там же в уста могут вложить любую заразу. И люди посмотрят, да это наш Президент или не наш?

Глава государства тогда же говорил: в связи с появлением нейросетей нас ждут тяжелые времена. И предупредил, что с этой технологией надо быть очень осторожными, поскольку «избежать этого мы не можем».

Кстати, совсем недавно Александр Лукашенко на встрече со студентами в МГЛУ рассказал, как искусственный интеллект сделал его уже настоящим полиглотом в интернете:

— Слушай, я на французском, немецком, испанском шпарю... Открой интернет, посмотри. В Парламенте выступаю на всех языках...

Сегодня думается, что Президент снова предвидел то, что готовит нам темная сторона цифрового будущего. Речь о возможных событиях, по сравнению с которыми отъем денег у людей покажется невинной забавой. А что, если нынешние упражнения компьютерных обманщиков по имитации чужих образов всего лишь обкатка технологий перед более угрожающим использованием нейросетей?

Представьте, что дежурному офицеру поступает видеозвонок от якобы всамделишного командира части, строго приказывающего открыть оружейную комнату и раздать автоматы группе гражданских, которые вот-вот подъедут на такой-то машине. Или требует заблокировать бронемашиной перекресток. Или срочно распустить личный состав ввиду угрозы удара с воздуха. Наверное, даже абсурдность приказа не сразу заставит ослушаться старшего командира. На это и будет расчет.Впрочем, хаос и неразбериха могут воцариться не только в воинских частях, но и на атомной станции, железнодорожном транспорте, нефтегазовой инфраструктуре, других критических объектах. Дипфейки, если использовать их в качестве информационного оружия массового поражения, способны парализовать страну — по крайней мере, на тот период, пока их будут разоблачать и опровергать.

Что же делать?

Проще сказать, чего делать не следует. Не надо позволять себе становиться тупым орудием в чужих руках. Несмотря на всю технологическую вооруженность IT-провокаторов, их расчет все-таки строится на том, что народная молва пока еще остается более массовым средством оповещения людей о какой-либо бредовой угрозе. Если вы увидели в интернете, что какой-либо высокопоставленный белорусский генерал внезапно выступил с националистическими лозунгами, не стоит немедленно обзванивать родных и знакомых с этой новостью. Не надо моментально лететь в родной коллектив с вестью, что якобы МЧС объявило о прорыве дамбы Минского моря и столицу вот-вот накроет гигантская волна. Не пугайте соседей только что увиденным видеороликом о высадке инопланетян в Крыжовке или интервентов в Ждановичах. Все то, что с первого взгляда выглядит как нелепица, слышится как галиматья и кажется чушью, скорее всего, и есть абсолютная чепуха. Несмотря на то, кто ее произнес в интернете.Нам надо привыкать мыслить критически. Пора понять, что нас будут регулярно пытаться обмануть, вывести из равновесия, напугать. Мы — объект постоянных манипуляций и регулярного раскачивания. Поэтому верим только официальным источникам и ничего не боимся.

КАК РАСПОЗНАТЬ ОБМАН

Разглядеть имитацию в современных дипфейках сложно, но все-таки возможно. Следует обратить внимание на следующие детали:

♦ аномалии в движениях и деталях. У человека, который появляется в фальшивом видео, бывают аномалии в движениях: например, неестественная, «нечеловеческая» мимика;

♦ необычное движение глаз. Собеседник с подменного видео редко моргает — деталь забавная, но работает безотказно;

♦ некорректное сопоставление голоса и губ. Вызвать подозрение также должно несоответствие между движениями губ и произносимыми словами.

rud@sb.by